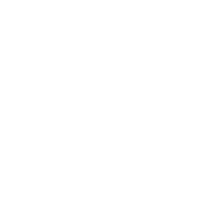

อ้างอิงข้อมูลจาก Green นั้น, Tesla เตรียมหันมาใช้กล้องรอบคันกะระยะวัตถุรอบคันแทน USS (Ultra Sonic Sensor) แล้วนะครับ โดยจะมีผลกับ Software 2022.45.11 เป็นต้นไปครับ

Update 2022.45.11 สำหรับ Tesla FSD Beta

update ล่าสุดที่กำลังจะออกมาเพื่อให้ Tesla Vision ทำงานแทน USS นั้นจะอยู่ใน update ของ Tesla FSD Beta ก่อนเท่านั้นนะครับ ซึ่งวันนี้(19/03/2023) เป็นวันแรกที่ Tesla ได้ทำการปล่อย update ออกมาครับ

แล้วใช้อะไรกะระยะ?

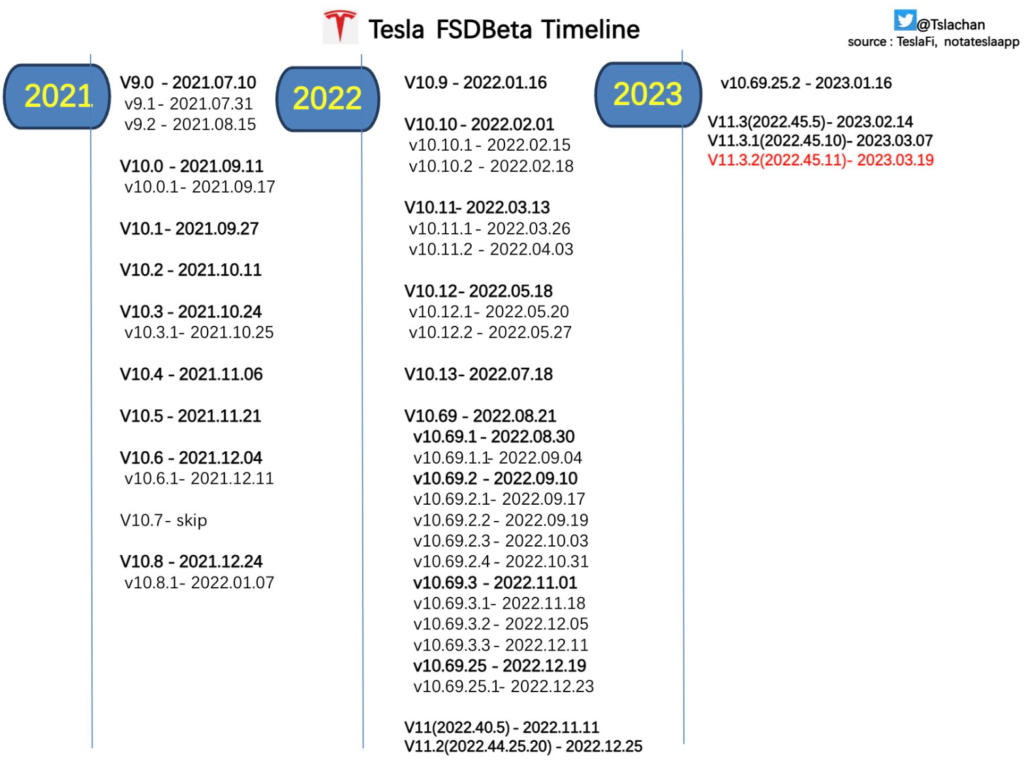

ตอนนี้ Tesla หันมาใช้ Occupancy Neural Network ในการกะระยะวัตถุรอบคันโดยเฉพาะตอนจอดนั้นก็ใช้ Occupancy Neural Network ในการสร้างวัตถุในกล้องให้กลายเป็นภาพ 3 มิตินะครับ

Occupancy Networks คืออะไร?

เราต้องมาทำความเข้าใจรากศัพท์คำว่า Occupancy (ออค’คิวเพินซี) แปลว่า การครอบครอง, การพำนักอาศัย, การมีถิ่นที่อยู่

Occupancy นั้นมีรากศัพท์มาจากคำว่า occupant ตามด้วยคำต่อท้าย(suffix) -cy

ส่วนคำว่า Networks ในที่นี้ไม่ได้แปลว่า หน่วยงาน Networks หรือ Internet แต่อย่างใดครับ แต่มันแปลว่า เครือข่ายนะครับ

ความหมายของคำว่า Occupant, Occupied, Occupancy นั้นจะมีความหมายเหมือนกันคือ ไม่ว่างหรือแปลว่ามีการครอบครองอยู่

ถ้าจะเปลี่ยนให้เห็นภาพก็เป็นภาพที่จะเห็นได้ในที่บานประตูห้องน้ำบนเครื่องบินนะครับว่า เวลามีเราเข้าห้องน้ำแล้วจะต้องเลื่อนกลอนเพื่อล๊อคประตู พอเราทำการเลื่อนกลอนแล้ว ป้ายด้านหน้าของห้องน้ำจะเปลี่ยนจาก Vacant (แปลว่า ว่าง) เป็น Occupied (แปลว่า ไม่ว่างหรือถูกครอบครองแล้ว) นั่นเองครับ พอเราปลดกลอนออกป้ายด้านหน้าจะเปลี่ยนเป็น Vacant เหมือนเดิม

คราวนี้พอเราเข้าใจรากศัพท์และความหมายของคำว่า Occupancy, Occupied, หรือ Occupant แล้ว พวกเราพอจะเดาได้หรือยังครับว่า Occupancy Networks แปลว่า อะไร?

ถ้าเอาสองคำนี้มารวมกันแล้วจะแปลว่า เครือข่ายที่ถูกจับจองพื้นที่นะครับ ผมแปลแล้วอาจจะงงๆ แต่ถ้าดูภาพด้านล่างทุกคนจะต้องรออ๋อเป็นเสียงเดียวกันแน่นอนครับ

ภาพด้านซ้ายนั้นคือ เก้าอี้ที่ render แบบออกมาเป็น 3D แบบทึบครับ ส่วนด้านขวานั้นจะเห็นได้ว่า มีจุดลอยไปในอากาศมากมายแต่สสารเหล่านั้นที่อยู่ในพื้นที่ของเก้าอี้ 3D นั้นจะเป็นสีแดงซึ่งนั่นคือ Occupancy (มีอยู่, ครอบครองตำแหน่งอยู่) ยังไงล่ะครับ

ถ้าจะให้ผลแปลแบบได้ใจความภายในบรรทัดเดียวก็คือ ระบบ Occupancy Networks คือการใช้ Deep Neural Network (โครงข่ายประสาทแบบลึก) ในการสร้างแบบจำลอง 3D (สามมิติ)มาจากภาพที่ AI เห็นครับ ไม่จำเป็นต้องเห็นครบ 360 องศาก็ได้ เพียงแค่เห็นภาพวัตถุนั้นบางส่วนก็สามารถจำลองภาพวัตถุเหล่านั้นให้กลายมาเป็น 3D ได้แล้วครับ

ข้อดีของ Deep Neural Network คือเวลามันไม่เห็นชิ้นส่วนทั้งหมดของสิ่งของชิ้นนั้น มันจะทำการ Gradient (เกลี่ย) ข้อมูลไป-มา(Ascent [ขึ้น] Descent [ลง]) เพื่อทำการสร้างวัตถุตัวนั้นขึ้นมา บางครั้งมันก็สร้างเหมือนของจริง บางครั้งก็มั่วไปไกล อันนี้แล้วแต่การตั้งค่า parameter (ค่าที่ต้องใช้งานในสมการ)ให้เหมาะสมกับการ Render ภาพ 3D (3 มิติ)ออกมาครับ หรือแปลเป็นไทยคือ Deep Neural Network มันสามารถคิด, วิเคราะห์เองได้(บางส่วน)และทำการจินตนาการเพิ่มเติมเพื่อให้ได้ผลลัพธ์ที่ดีขึ้นออกมาครับ

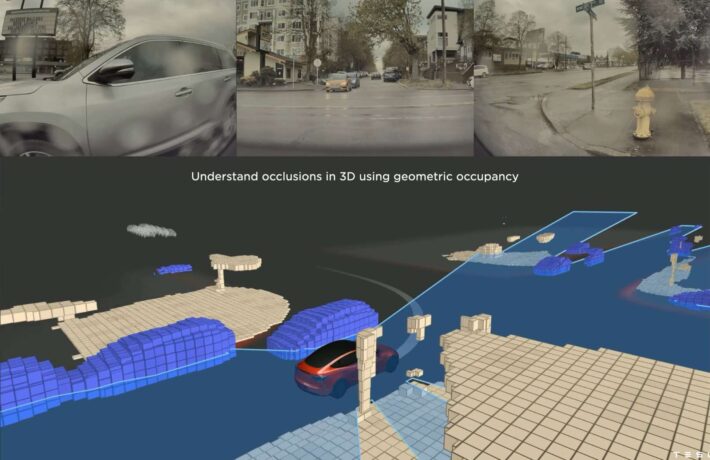

โดยการฝึก(train) Occupancy Network นั้นจะใส่ input เข้าไปแล้วทำให้ระบบ Neural Network ฝึกสร้างแบบจาก input ตัวนั้น แล้วจากนั้นเราจะทำการเฉลยโดยเอาภาพของจริง (Ground Truth)มาให้ระบบทำการเปรียบเทียบแล้วจะมี AI อีกส่วนเรียกว่า Testing มาให้คะแนน AI ที่สร้างภาพเอาไว้นะครับ

ส่วน Model ในการ Train นั้นก็มีให้เลือกมากมายครับ Model สำหรับ Train ก็จะเปรียบเหมือนเครื่องมือที่เอาไว้ใช้สำหรับทำงานนะครับ แต่ล่ะ Model ก็มีความโดดเด่นเฉพาะตัวในการทำงานแตกต่างกันออกไปครับ

ใครสนใจเรื่อง Occupancy Networks นั้นสามารถอ่านต่อได้ที่ castu และสามารถเอา Code จาก github มารันเล่นดูได้นะครับ

Occupancy Networks เกิดขึ้นครั้งแรกในปี 2016?

อย่างนึงที่ผมอยากเรียนให้ทราบตรงนี้คือ Tesla ไม่ได้เป็นคนคิดค้น Occupancy Networks นะครับ หลักการ Occupancy Networks ถูกสร้างขึ้นในปี 2019 โดยคณะนักวิจัยจากมหาลัย University of Tubingen ประเทศเยอรมันครับ ซึ่งตอนแรกนั้นเค้าเพียงคิดค้นการเปลี่ยนภาพ 2 มิติให้เป็น Voxel (ปริมาตรที่เล็กที่สุดที่รวมตัวกันเป็นภาพสามมิติ) หรือจะเห็นได้ใน pixel ในเกมส์ MineCraft ครับ ภาพจำลองแบบ Voxel นั้นถูกคิดค้นในปี 2016 ครับ ซึ่งตอนนั้นไม่ได้เรียกระบบนี้ว่า Occupancy Networks เนื่องจากความสมบูรณ์แบบนั้นยังไม่เยอะเท่าที่ควร

ในปีถัดๆ มาก็ได้มีนักวิจัยช่วยกันมาพัฒนาระบบการวิเคราะห์ภาพถ่ายจาก 2 มิติเป็น 3 มิติไปเรื่อยๆ จนในปี 2019 นั้นทางมหาลัย University of Tubingen ก็ได้สร้าง Model ในการจำลองภาพ 3 มิติอย่างที่เห็นด้านบน(d) Our ครับ คือภาพที่จำลองออกมานั้นสมบูรณ์แบบและมีความ accurate (แม่นยำ) ใกล้เคียงภาพ 3 มิติจาก Ground Truth (ภาพ Final) จริงๆครับ

เค้าจึงได้ตีพิมพ์บทความกระจายออกไปในปี 2019 พร้อมกับใส่ code Github ทิ้งเอาไว้เพื่อให้ทุกคนได้ศึกษาและนำไปพัฒนากันต่อตามใจชอบและมันก็ไปโดนใจทีมพัฒนา FSD Beta ของ Tesla พอดีนั่นแหละครับ จึงเป็นที่มาของ Tesla Occupancy Networks

NeRF คือเครื่องมือที่ Tesla นำมาใช้

จริงๆ แล้ว เรื่อง Occupancy Networks นั้นยาวมากๆครับ จะเอามาเขียนทั้งหมดในโพสนี้ก็คงจะปวดหัวน่าดูแต่อยากให้จำ Keyword (คำสำคัญ)สำหรับระบบนี้เอาไว้ 2 คำคือ “Queryable Outputs” และ “NeRFs” ซึ่งถ้ามีเวลาผมจะมาลงรายละเอียดเพิ่มเติมให้วันหลัง หลักๆคือ 2 ตัวนี้มีหน้าที่เปลี่ยนภาพถ่าย 2 มิติให้กลายเป็น 3 มิติโดยใช้ภาพเพียง 2-3 ภาพก็สามารถเปลี่ยนภาพนั้นให้กลายเป็นวัตถุ 3 มิติได้แล้วครับ

ลองคิดตามผมนะครับว่าแค่ได้ภาพไป 2-3 ภาพก็ใช้ NeRFs ทำภาพ 3 มิติได้แล้ว คราวนี้ กล้องรอบรถ Tesla มี 8 ตัวและวิ่งด้วยความเร็ว 24 fps (หรือ 24 ภาพต่อวินาที) เท่ากับว่าเค้าสามารถจับภาพต่างๆ ได้มากกว่า 100 ภาพภายใน 4 วินาทีซึ่งแค่นี้ก็เพียงพอที่จะเอามาใช้เป็น dataset (ชุดข้อมูล)ในการประมวลผล NeRF เพื่อสร้างวัตถุ 3D หรือสามมิติรอบรถแล้วครับ

อย่างไรก็ตาม Concept เหล่านี้อยู่ในห้อง Lab (ห้องวิจัย)มานานตั้ง 3-4 ปีแล้วครับ เทสล่าเพียงหยิบงานวิจัยเหล่านี้ขึ้นมาแล้วเอามาใช้กับ Industry ของตนครับ เอาล่ะครับ เดี๋ยวเราจะมาดูกันว่า Tesla พัฒนาต่อยอดงานวิจัยเหล่านี้ไปถึงไหนกันนะครับ

อ่านต่อเรื่อง Occupancy Neural Network

BLINK DRIVE TAKE

Tesla Vision แทน USS??

ก่อนอื่นผมต้องบอกว่าช่วงแรก Tesla จะใช้ software update ตัวนี้กับรถที่ไม่มี USS ติดมานะครับ ไม่ว่าจะเป็น Tesla Model Y 2023, Model 3 2023, Model S 2023, และ Model X 2023 ซึ่งถ้าใครได้ update เป็น software version 2022.45.11 แล้วจะสามารถเปิดใช้งานระบบที่เอากล้องมาใช้แทน USS ได้ทันทีครับ

อย่างไรก็ตาม Tesla คันไหนที่มี USS อยู่นั้น ทาง Tesla ยังเปิดให้ใช้งานไปก่อนครับ แต่ยังไม่มีการยืนยันว่าจะปิดใช้งาน USS เมื่อไหร่กันนะครับ