พรุ่งนี้(28/08/23)เป็นต้นไปจะเป็นการเปิดศักราชใหม่ของ Tesla ด้วยการเดินเครื่อง training ด้วยการ์ด nvidia H100 ทั้งหมด 10,000 ใบในการ train FSD (Full Self Driving) กันนะครับ พวกเราสงสารกันใช่ไหมครับว่า nvidia H100 นั้นแรงแค่ไหนกัน? โพสนี้มีคำตอบให้ครับ

การ train AI คืออะไร?

การ train AI ใน deep learning นั้นมีหลากหลายไลบรารี่ (library) – [เปรียบเสมือนโปรแกรมสำเร็จรูปที่เก็บฟังก์ชันการทำงานที่เฉพาะทาง] ในการเทรนนะครับ แต่ถ้าไลบรารี่ตัวท๊อปของโลกที่ใช้ในการเทรนนั้นจะมี 2 ตัวหลักๆ ครับคือ

- PyTorch – สร้างโดย Facebook

- Tensorflow – สร้างโดย Google

โดยแต่ล่ะค่ายก็มี libraries ซอยย่อยลงไปสำหรับการใช้งานต่างๆ ที่แตกต่างออกไปครับ ผมไม่ขอเจาะลึกรายละเอียดไลบรารี่เหล่านี้ในโพสนี้ครับ แต่อย่างที่นักเทรน Deep Learning รู้กันคือ Tesla FSD นั้นถูก train อยู่บนไลบรารี่ของ Pytorch ครับ(ที่มา : Rapidops) ซึ่งคนที่ตัดสินใจที่จะใช้ Pytorch ในการเทรนนั้นก็ไม่ใช่ใครอื่นไกล นั่นก็คือ Andrej Karphathy หรือ the fahter of Autopilot (บิดาแห่ง Tesla Autopilot)ครับ

ถ้าจะให้อธิบายหลักการ train AI โดย pytorch ผมคาดว่าต้องเขียนโพส 3-4 โพสให้ทุกคนอ่านเพื่อให้เข้าใจ แต่ยังไงโพสนี้ผมขอสรุปการ train AI แนวทาง Deep learning แบบสั้นๆคือ การ train AI(ฝึกปัญญาประดิษฐ์) คือการสอน AI ให้แก้ไขปัญหาโดยตัวอย่างที่ถูกต้องและตัวอย่างที่ผิดให้ AI เรียนรู้และให้ AI ฝึกตัดสินใจด้วยตัวเองไปเรื่อยๆ(วนเป็นล้านๆ รอบ) เพื่อหาแนวคิดที่ถูกต้องที่สุดออกมา หรือจะเรียกว่าสอน AI ให้ฉลาดขึ้นครับ

โดยการเทรนเหล่านั้นจะใช้ Neural network (โครงข่ายใยประสาท)เป็นล้านๆ nodes ในการประมวลผลครับ การประมวลผลผ่าน nvidia CUDA นั้นจะประมวลแบบ parallel processing หรือคู่ขนานไปพร้อมๆ กัน ซึ่งถ้าใช้การทำงานแบบ CPU (sequence processing) ก็นานแสนนานเลยครับ ทำให้การ์ดจอ nvidia เข้ามามีบทบาทในโลก AI มากขึ้นในช่วง 2-3 ปีมานี้ครับ

ถ้าเข้าใจ concept กันแล้วก็ไปต่อทาง hardware กันเลยครับ

nvdia ตระกูล Deep learning AI series คืออะไร?

ก่อนอื่นต้องมาทำความรู้จักการ์ดสำหรับ train AI (ฝึกให้ AI ฉลาดขึ้น)กันก่อนนะครับ การ์ดจอที่ใช้ train AI Deep learning (แบบ GPU) แบบโหดๆ (แรงๆ)บนโลกนี้มีแค่ยี่ห้อเดียวครับ นั่นก็คือ nvidia สาเหตุที่มีแค่ยี่ห้อนี้ยี่ห้อเดียวเพราะมันมีเทคโนโลยี CUDA (Compute Unified Device Architecture) ซึ่งเป็นเทคโนโลยีในการประมวลข้อมูลแบบ parallel (คู่ขนาน)ครับ

และกลายเป็นว่า Nvidia นั้นถือลิขสิทธิ์นั้นเอาไว้แต่เพียงผู้เดียว(อันนี้ใครมีข้อมูลว่าค่ายอื่นใช้งานได้บอกหน่อยนะครับ) ส่วนอีกเจ้าคือ Apple ที่ใช้งาน M1 Ultra ในการ train Deep learning ใน pytorch ได้ครับแต่ก็ยังไม่แพร่หลายเท่า CUDA จากค่าย nvidia ครับ

ดังนั้น นักวิจัยทั่วโลกและอุตสาหกรรมที่ใช้งาน AI ต่างกันหันมาล่าซื้อการ์ดจอกันอย่างจ้าละหวั่นครับจนอีลอนพูดติดปากว่า

พวกเราอยู่ในยุคที่การ์ดจอหาซื้อยากกว่ายาบ้าไปเสียแล้ว

“GPUs at this point are considerably harder to get than drugs,”

อีลอน มัคส์ได้ให้สัมภาษณ์เอาไว้กับ WSJ

Nvidia H100 แรงแค่ไหน?

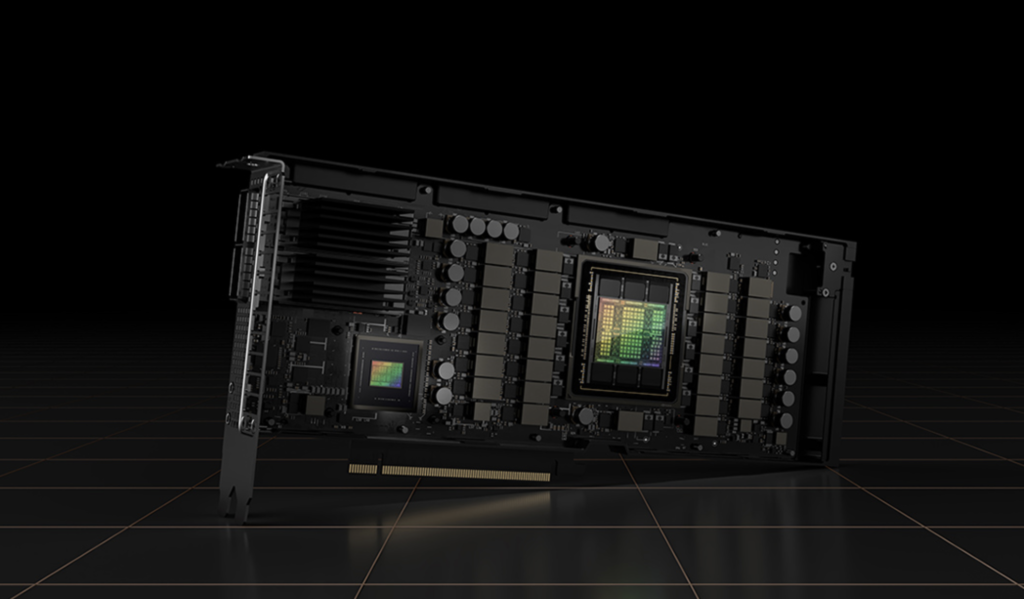

การ์ดจอสำหรับเล่นเกมส์ตัว top ๆ อย่าง RTX 4090 นั้นราคากระชากขึ้นเกือบเท่าตัวหลายจากเปิดตัวก็เพราะเรื่องนี้เช่นกันครับ แต่ยังไงก็ตามมันก็ยังไม่ใช่ตัว Top ในการประมวลผลครับ เพราะ RTX 4090 นั้นมี RAM เพียง 24 GBs และมีความแรงเพียง 40 % ของการ์ดจอ RTX H100 (Ram 80 GBs)เองนะครับ

ถ้าเปรียบเทียบให้เห็นภาพมากกว่านี้คือ ถ้าจะ train LLM ของ ChatGPT นั้น nvidia H100 สามารถรองรับการ train ได้มากถึง 65 พันล้าน paramter ส่วน RTX 4090 รองรับได้เพียง 6 พันล้าน parameter หรือต่างกันปประมาณ 10 เท่าตัวครับ – ที่มา wccftech

การ์ด AI ใบละ 1.4 ล้านบาท, Tesla ครอบครองอยู่ 10,000 ใบแล้ว

แต่ก็อย่างที่ทราบกันคือ Nvidia H100 ประมวลผลเกมส์ได้แย่มากๆ ส่วน RTX 4090 นั้นก็ประมวลผล AI สู้ H100 ไม่ได้ดังนั้นเราคงเอามาเปรียบเทียบกันไม่ได้ตรงๆ ครับ แต่อยากสรุปคือ nvidia พยายามสร้างการ์ดแบ่งแยกตลาดจริงจังไปเลยแบบว่า การ์ดจอเล่นเกมส์ 1 ตลาดและการ์ดสำหรับ train AI เป็นอีกตลาด สิ่งสำคัญคือการ์ด train AI นั้นแพงแบบหูฉีกไปเลยครับ อย่าง Nvidia RTX 4090 ตัวtopของตลาดนั้นใบนึง 61,900 – 70,000 บาท(แพงมากๆครับ) ส่วน Nvidia RTX H100 นั้นราคาทะลุ 1.4 ล้านบาทไปแล้วครับ(ที่มา amazon)จริงๆ ราคาเริ่มต้น H100 นั้นประมาณ $30,000 หรือ 1 ล้านบาทครับ แต่พอเปิดขายปุ๊บของหมดปั๊บเลย ไม่ว่าจะเติมของเท่าไหร่ก็หมดทันทีวันรุ่งขึ้นครับ เพราะบริษัทต่างๆ กว้านซื้อไปหมดเลย รวมไปถึง Tesla ด้วยที่กว้านซื้อคนเดียว 10,000 ใบครับ(หรือเทียบเท่าเงิน 14,000 ล้านบาท)

H100 แรงกว่ารุ่นพี่ A100 ถึง 9 เท่า

อย่างที่ทราบกันมาว่า ChatGPT นั้นใช้ nvidia A100 (ผลิตครั้งแรกปี 2020) และการ์ดจออื่นๆ รวมถึง 20,000 ใบในการ train ChatGPT V4.0 นะครับ แต่กลายเป็นว่า nvidia H100 ที่ออกมาใหม่นั้นมีประสิทธิภาพในการ train AI ดีกว่า nvidia A100 ถึง 9 เท่าและแพงกว่าถึง 3 เท่าครับ

สเปค Nvidia A100

- 6,912 CUDA cores

- 432 tensor cores

- 40 GB or 80 GB of high-bandwidth memory (HBM2)

สเปค Nvidia H100

- 18,432 CUDA cores

- 640 tensor cores

- 80 streaming multiprocessors (SMs)

- Higher energy usage than A100

แม้ว่า Nvidia จะสามารถส่งการ์ด nvidia H100 ให้ Tesla ได้ถึง 10,000 ใบก็ตาม อีลอนก็ยังบอกว่า มันก็ยังไม่เพียงพอต่อการ train FSD เลย เพราะ Tesla Dojo Center ของ Tesla นั้นมีมูลค่า 1 พันล้านเหรียญสหรัฐหรือ 35,000 ล้านบาทหรือถ้าจะให้เทียบเท่าเป็นอาคารก่อสร้างก็มูลค่าเท่ากับ Tesla Gigafactory 1 โรงงาน(มูลค่า 1.1 พันล้านเหรียญ)ครับ อีลอนบอกว่า Tesla Dojo ของเค้าจะกลายเป็น Top5 (หนึ่งในห้า) Supercomputer ของโลกไปทันทีที่สร้างเสร็จภายในต้นปี 2024 ครับ

อีลอนเคยขอให้ nvidia ขายการ์ดให้ทั้งหมด

เอาตรงๆ เลยนะ ถ้า Nvidia สามารถส่งมอบ GPU ให้เราได้ตามความต้องการของเราแล้วล่ะก็ เราคงไม่เสียเวลามาสร้าง Dojo อันนี้หรอก

“Frankly…if they (NVIDIA) could deliver us enough GPUs, we might not need Dojo.”

อีลอน มัคส์

Tesla FSD V12 ยังไม่คลอดเพราะการ์ด AI ไม่เพียงพอ

Tesla FSD V12 ที่เรียกได้ว่าเป็นเวอร์ชั่นเปลี่ยนโลกนั้นยังไม่สามารถนำออกมาใช้งานได้เพราะตอนนี้ Tesla ประสบปัญหาขาดแคลนการ์ดจอในการ train AI อย่างหนักมากๆ คือ Tesla ได้ลงทุนไปแล้ว 2 พันล้านเหรียญ(หรือเทียบเท่ากับการสร้าง Gigafactory Texas 2 โรงงาน)กับการ train AI ซึ่งมันไม่เพียงพอจริงๆ

อย่างไรก็ตาม Tesla ตั้งเป้าจะสร้างพละกำลัง AI Supercomputer เอาไว้ที่ 13 Exaflop ภายในปี 2023 และ 100 exaflop ภายในปี 2024 (หรือเทียบเท่าความแรง Nvidia H100 ประมาณ 25,000 ใบ)

แม้ว่า Tesla ไม่ได้กล่าวถึง D1 Chipset นั้นแต่ในงบ 2 ล้านเหรียญนั้นเป็นงบที่มีการสร้าง data center ที่มี D1 Chipset รวมอยู่ด้วยครับ

ที่มา : tech insight