อีลอน มัคส์ (CEO Tesla) ทำการเปิดตัวหุ่นยนต์ Humanoid (รูปทรงเหมือนมนุษย์)นามว่า Optimus ที่ใช้งาน Software AI ที่มีพื้นฐานมาจาก Tesla FSD Beta Software ในรถยนต์ไฟฟ้า Tesla มาใช้งานกับหุ่นยนต์ตัวนี้นะครับ อย่าง hardware ตรงกลางหน้าอกของหุ่นยนต์ Optimus ตัวนี้ก็คือ Full Self-Driving Computer ที่อยู่ใน Tesla Model 3 เลยล่ะครับ

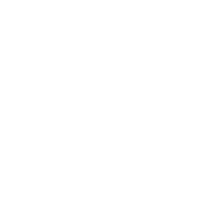

อีลอนบอกว่า หุ่นยนต์ที่ทุกท่านเห็นนั้นถูกพัฒนามาจากปี 2021 ที่แล้ว(1 ปี)ดังนั้นยังมีข้อผิดพลาดอยู่มากและยังไม่สมบูรณ์แบบ 100% ที่จะนำมาขายนะครับ

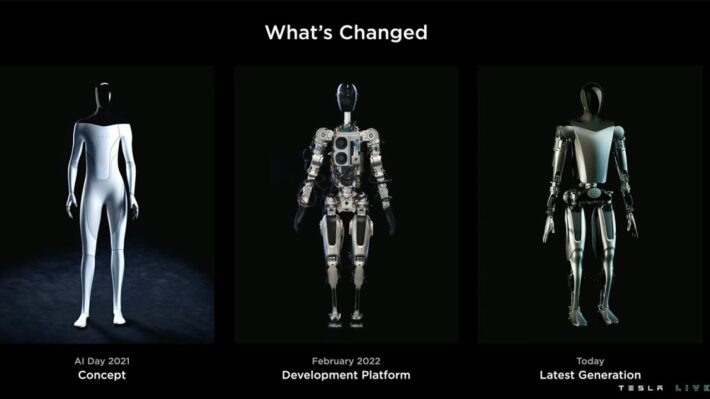

อีลอนยังพูดอีกว่า “งานเปิดตัวนี้เป็นครั้งแรกที่หุ่นยนต์ตัวนี้ทำงานได้ด้วยโดยไม่ต้องพึ่ง a tether (สายแพร์)เสียบกับตัวหุ่นยนต์ครับ” อย่างไรก็ตามอีลอนบอกว่า เราจะทำหุ่นยนต์ที่ทุกคนสามารถซื้อมาใช้งานได้ ซึ่งราคาขายของหุ่นยนต์ตัวนี้จะไม่เกิน $20,000 หรือ 740,000 บาทหรือถูกกว่ารถยนต์ไฟฟ้า ORA Good Cat อีกนะครับ

หุ่นยนต์ตัวนี้ทำอะไรได้บ้าง?

อีลอนบอกว่า อันนี้เป็นเฟสเริ่มต้นดังนั้น หุ่นยนต์ยังทำอะไรไม่ได้มากไปกว่า ยกกล่องกระดาษ, รดน้ำต้นไม้หรือหยิบของไปวางอีกที่นึงครับ โดยวิศวกรโปรเจค Optimus นั้นได้บอกว่า หุ่นยนต์ตัวนี้จะสามารถมองเห็นภาพต่างๆ เหมือนที่ Tesla Model 3 มองเห็นภาพต่างๆ บนท้องถนนผ่าน software Tesla FSD Beta เลยนะครับ

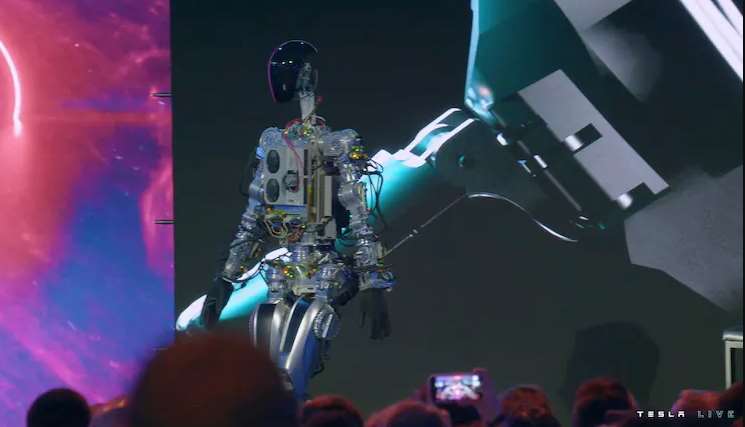

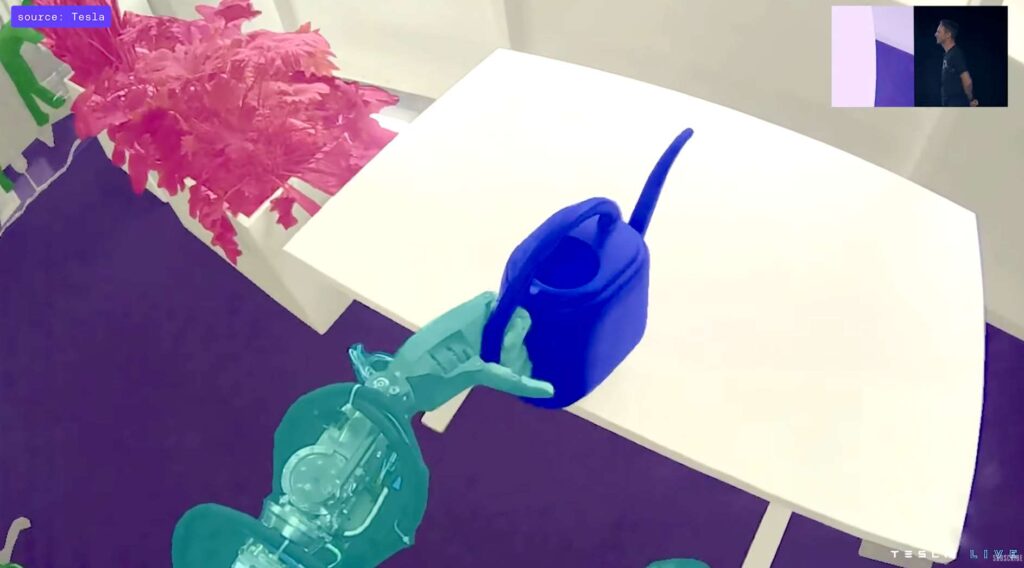

อย่างภาพด้านบนนี้คือ หุ่นยนต์หยิบกล่องไปวางไว้บนโต๊ะ ส่วนภาพด้านขวามือคือภาพที่มาจากลูกตา(กล้อง)ของหุ่นยนต์ครับ ภาพด้านขวานั้นคือสิ่งที่หุ่นยนต์เห็นและทำการสั่งการเองโดยไม่ได้มี input จากมนุษย์แต่อย่างใดครับ อารมณ์เหมือน Tesla FSD Beta ว่าปักหมุดว่าให้ขับไปตรงไหนแล้วเดี๋ยวทำเองได้นะครับ

อย่างภาพด้านบนนี้(หุ่นยนต์รดน้ำต้นไม้) หุ่นยนต์จะสามารถแยกแยะ แจกแจงวัตถุต่างๆ เป็นสีต่างๆ ในภาพครับ หุ่นยนต์จะแยกเองได้ว่าวัตถุไหนจับต้องได้เพื่อนำมาใช้งาน(ที่รดน้ำต้นไม้) วัตถุไหนอยู่กับที่(โต๊ะ) หรือวัตถุเป้าไม้(ต้นไม้) เป็นต้นครับ

หลักการการทำงานตรวจจับวัตถุต่างๆ นั้นเอามาจาก software Tesla FSD เกือบทั้งหมดและมาเขียน library บางส่วนเพื่อให้หุ่นยนต์สามารถ interact (มีปฏิสัมพันธ์)กับวัตถุนั้นๆครับ

BLINK DRIVE TAKE

พอเห็นหุ่นยนต์ตัวนี้ ก็อดนึกถึงหนังเรื่อง iRobot ไม่ได้เลยนะครับ อนาคตเราคงจะได้เห็นหุ่นยนต์เหล่านี้เดินทั่วไปตามท้องถนน ส่วนพวกเราคงนอนเป็นผักอยู่ในห้องนอนพร้อมแว่น VR (Virtual Reality) เหมือนในหนังเรื่อง Surrogates ล่ะมั้งครับ ฮ่าๆ

เดี๋ยวผมจะทยอยแปลบทความเกี่ยวกับ Tesla AI Day ให้ทุกท่านได้อย่างกันนะครับ คาดว่าจะใช้เวลา 3-4 วันและต้องเขียนบทความแยกย่อยเกี่ยวกับ Tesla AI Day ประมาณ 5-10 บทความเพื่อให้ครอบคลุมทั้งหมดนะครับ